Colinealidad Imperfecta

Este supuesto hace referencia a que nuestros regresores deben ser linealmente independientes. Matemáticamente esto significa que el inverso de $(X'X)^{-1}$ existe. La independencia lineal significa que cada variable aporta información adicional en la regresión; esto es, que una variable explicativa no es un múltiplo de otra ni una combinación lineal de otras (Montenegro, 2018). En la practica nuestros regresores podrán estar correlacionados entre ellos siempre y cuando uno no sea una combinación lineal de otro.

¿Porque no podemos tener regresores con colinealidad perfecta?

Esto hace que el calculo de $(X'X)^{-1}$ sea imposible dado que obtendremos un determinante de 0. Dado esto tendremos infinitas soluciones para $ \beta = (X'X)^{-1}X'Y$.

¿Que pasa cuando hay multicolinelidad?

Si la multicolinealidad no es perfecta no deberíamos tener mayor problema (los estimadores de MCO siguen siendo MELI). Aun así, cuando presentamos problemas de multicolinealidad veremos que nuestros estadísticos t tienden a indicar no significancia estadística. Esto ocurre dado que los errores estándar de la regresión tienden a aumentar bajo este problema.

¿Como detectar multicolinearidad?

- Alta correlacion entre los regresores

- R cuadrado alto con estadisticos t bajos

- Factor de incremento de varianza alto (VIF > 8)

Factor de Incremento de Varianza

Tomando la varianza de los estimadores de OLS: $$Var(\hat{\beta_{1}}) = \left(\frac{\sigma^{2}}{\sum (X_{i} - \bar{X})^{2}}\right)\left(\frac{1}{(1-r^{2})}\right)$$Veremos que el VIF es este termino a la derecha de la formula de la varianza, el cual puede estar afectando nuestra varianza cuando tenemos problemas de multicolinealidad.

$$VIF = \frac{1}{(1-r^{2})}$$En el caso de una regresión simple, este $r^{2}$ sera:

$$ r^{2} = [Corr(x_{1}, x_{2})]^{2} $$En el caso de una regresión múltiple, este $r^{2}$ es el $R^{2}$de la regresión de $x_{1}$ en los demás regresores, siendo $x_{1}$ el regresor que creemos que esta muy correlacionado con los demás.

De esta forma vemos que cuando este termino $r^{2}$ es muy grande (recordemos que este numero estará entre 0 y 1), el denominador del VIF tendera a acercarse a 0 y el VIF tendera a aumentar, aumentando de esta forma la varianza de nuestros estimadores.

Veamoslo en stata

Usando la base de datos bwght de Wooldridge vamos a estimar un modelo que nos ayude a ver el efecto de los cigarrillos sobre el peso de los recién nacidos. Uno primer modelo que podríamos usar es el siguiente, donde incluimos regresores con información de el precio de los cigarrillos, impuestos a los cigarrillos y el consumo diario de cigarrillos:

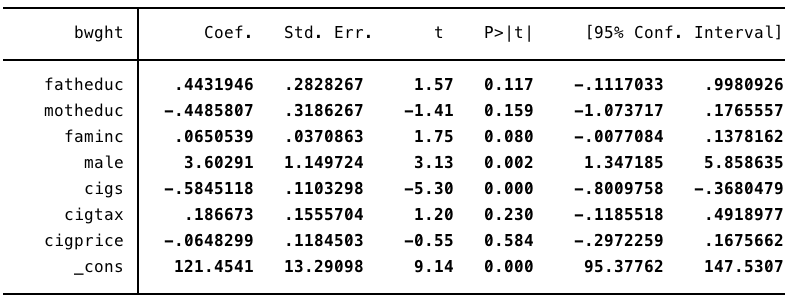

reg bwght fatheduc motheduc faminc male cigs cigtax cigprice

Como podemos ver, las variables de cigarillos tienden a no ser significativas, pero tenemos la sospecha de multicolinelidad. Veamos si es el caso:

Calculemos los coeficientes de correlación de nuestros regresores. Cabe resaltar que esto no es un test estadístico con valores críticos, pero puede ayudarnos a ver si nuestras variables están altamente correlacionadas entre ellas.

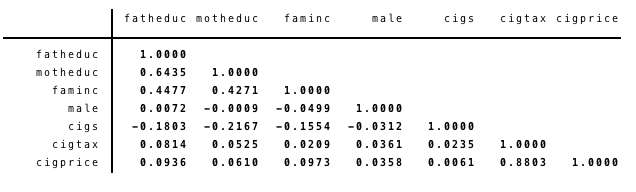

corr fatheduc motheduc faminc male cigs cigtax cigprice

Vemos una correlación muy alta entre algúnos de nuestros regressores. Veamos el VIF manualmente.

Como sabemos el termino de $ r^{2} $ en la formula del VIF viene del coeficiente de la regresión de $ x_{1} $ en los démas regresores.

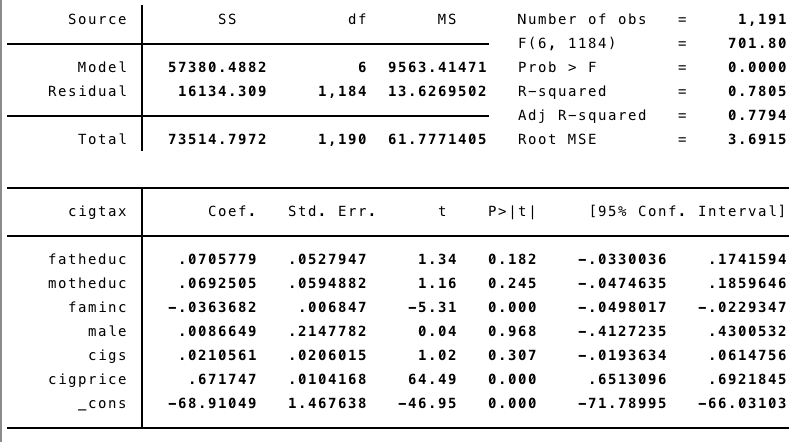

reg cigtax fatheduc motheduc faminc male cigs cigprice

El R cuadrado es de 0.7805. Con este valor podemos calcular el VIF

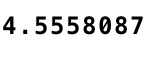

dis 1/(1-0.7805)

De aquí sabremos que la varianza de nuestro estimador de cigs es 4.5 veces mas grande gracias a la multicolinealidad.

Una forma mas sencilla de llegar a este resultado es usando el comando "vif" en stata justo después de realizar la regresión que habíamos planteado originalmente:

qui reg bwght fatheduc motheduc faminc male cigs cigtax cigprice

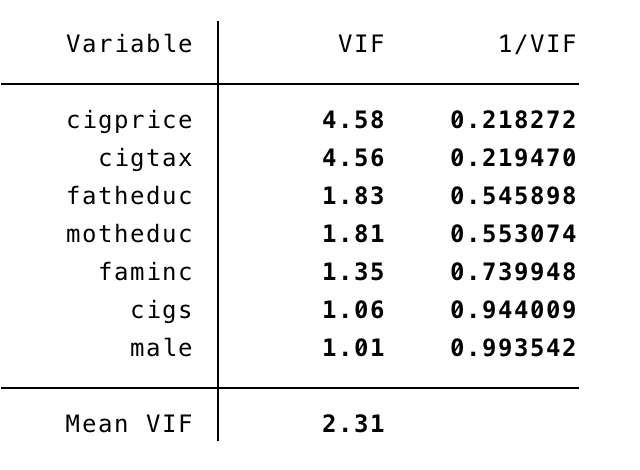

vif

Ahora podemos ver el VIF de todos los demas regresores.

¿Que hacemos ahora?

Como se menciono anteriormente, esta no es una prueba estadística en la que tengamos valores críticos o p values. Usualmente se dice que la multicolinelidad es un problema cuando el VIF es mayor a 5. Intuitivamente podríamos pensar que este es un problema grave cuando hace que mis regresores dejen de ser significativos. Para este tipo de casos es importante guiarse de la intuición y aprovechar las herramientas que tenemos disponibles como el VIF para darnos una idea mas clara de la multicolinealidad y de la prueba F la cual no se ve afectada por este problema. Hay que tener en cuenta la relación que puede existir entre nuestros regresores y si valdría la pena mantener o eliminar alguna variable.

Bibliografía:

- Verbeek, M. (2004), A Guide to Modern Econometrics.

- Wooldridge, Jeffrey M. (2018), Introductory Econometrics: A Modern Approach, Sixth Edition, Cengage Learning.

- Montenegro, A. (2018), Econometría Intermedia y Básica.